به گزارش بازار به نقل از نشریه زاویه، ظهور هوش جامع مصنوعی (AGI) بهمثابه تحولی بنیادین در منظومه فناوری و امنیت جهانی، نهتنها بهعنوان یک ابزار فناورانه، بلکه بهمثابه یک عامل ساختارشکن در نظم ژئوپلیتیکی موجود مطرح است. گزارش تازه مؤسسه رَند [۱] با رویکردی آیندهنگر و مبتنی بر سناریونگاری، میکوشد پیامدهای احتمالی توسعه AGI بر نظم جهانی، توازن قدرت و بقا یا زوال دولتها را به تصویر بکشد.

این گزارش با هدف ترغیب سیاستگذاران به تفکر درباره پیامدهای بالقوه توسعه هوش جامع مصنوعی بر ژئوپلیتیک و نظم جهانی تنظیم شده است. این گزارش بر بزرگترین پیامدهای احتمالی ناشی از توسعه و بهکارگیری AGI تمرکز دارد، پیامدهایی که شاید احتمال وقوعشان پایین باشد اما در صورت وقوع، بسیار مهم و تأثیرگذارند و میتوانند نظم ژئوپلیتیکی موجود را بهکلی دگرگون کنند.

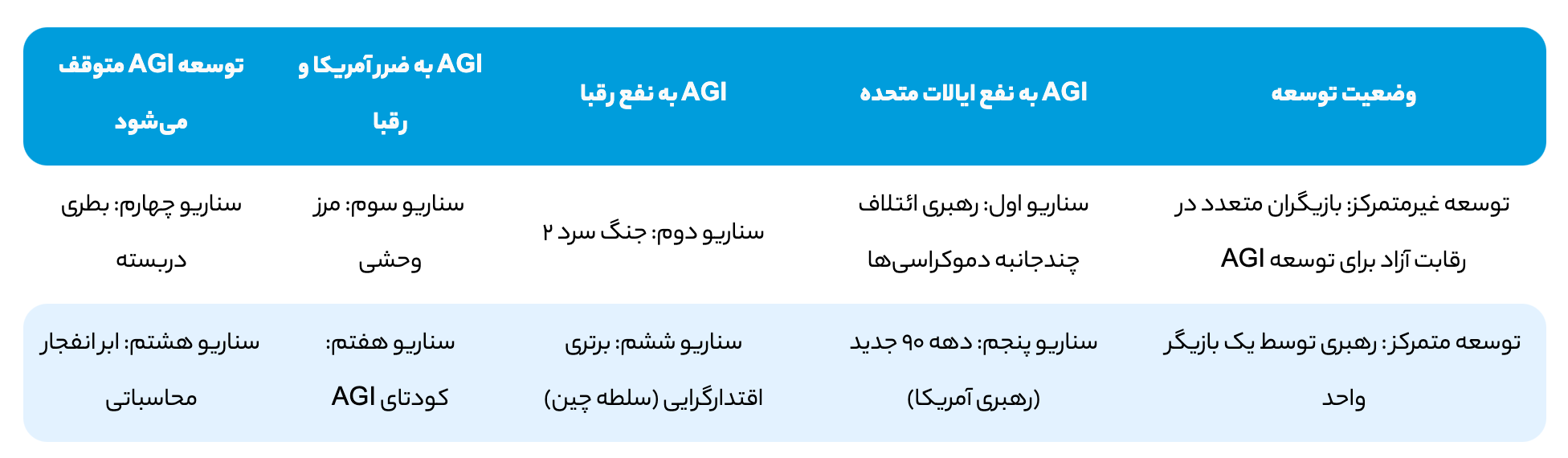

برای کمک به تفکر درباره این پیامدهای بالقوه و تغییردهنده جهان، این گزارش هشت سناریوی توصیفی را ارائه میدهد که بر درجه تمرکز یا عدم تمرکز در توسعه AGI و نتایج ژئوپلیتیکی آن تمرکز دارند. این سناریوها شامل تأثیراتی هستند که ممکن است به نفع ایالات متحده، به نفع رقبا، منجر به دگرگونی ژئوپلیتیکی اساسی یا حتی توقف توسعه AGI شوند. این سناریوها به منظور نشان دادن این نکته طراحی شدهاند که میزان تمرکز در توسعه AGI یک عامل تعیینکننده در نتایج ژئوپلیتیکی آینده است.

در سناریوهای متمرکزتر، یا ایالات متحده یا یک قدرت رقیب میتواند برتری چشمگیری کسب کند؛ در حالی که توسعه غیرمتمرکز ممکن است به ظهور یک نظم چندقطبی جدید یا بیثباتی ژئوپلیتیکی بینجامد، بهویژه اگر بازیگران غیردولتی به واسطه AGI قدرت زیادی کسب کنند.

هوش جامع مصنوعی چیست و چرا اهمیت ژئوپلیتیکی دارد؟

همانطور که در این گزارش تعریف شده است AGI یعنی نوعی هوش مصنوعی که بتواند هر کار فکری را که انسان قادر به انجام آن است انجام دهد و میتواند حوزههای گوناگونی از حیات ملی از جمله سیاست، اقتصاد، امنیت ملی و موارد دیگر را دگرگون کند.

ما همین حالا نیز اثرات قابل توجهی از هوش مصنوعی را مشاهده میکنیم. اقتصاددان دیوید دِمینگ برآورد میکند که هوش مصنوعی همین حالا در بازار کار ایالات متحده، در انجام نیمی از وظایف برای نیمی از مشاغل، نقش ایفا میکند. مطالعهای از اریک برینیولفسون و همکارانش نشان میدهد که ابزارهای هوش مصنوعی موجود، بهرهوری را تا ۱۴٪ افزایش دادهاند. برآورد مؤسسه مککینزی گلوبال حاکی از آن است که هوش مصنوعی ممکن است تا سال ۲۰۳۰ بین ۴۰۰ تا ۸۰۰ میلیون شغل را به صورت جهانی خودکارسازی کند که این امر شوکی لرزهآسا بر بازار کار جهان وارد خواهد کرد.

ابعاد تأثیرگذاری هوش مصنوعی، فراتر از بهرهوری اقتصادی و پیشرفتهای علمی است. در حوزه نظامی، بهبود تحلیل دادهها و پیشرفتهای فناوری در تسلیحات خودمختار، راهبردها و توانمندیها را بهطور چشمگیری دگرگون کردهاند. با این حال، دگرگونی ژئوپلیتیکی واقعی شاید هنوز فرا نرسیده باشد و با ظهور AGI و در نهایت هوش مصنوعی ابرهوشمند (ASI)، یعنی زمانی که ماشینها توانایی پیشیگرفتن از انسان در تمامی حوزهها را پیدا کنند، رخ دهد. در یک نظرسنجی از پژوهشگران برتر هوش مصنوعی در کنفرانسهای طراز اول، تخمین زده شد که احتمال عبور ماشینها از تواناییهای انسانی در همه زمینهها تا سال ۲۰۴۷ برابر با ۵۰٪ است.

چارچوب تحلیلی مؤسسه رند؛ از تمرکز توسعه تا پیامدهای قدرتساز

محور تمرکز از توسعه کاملاً متمرکز توسط یک بازیگر واحد یا یک ائتلاف کوچک، تا توسعه غیرمتمرکز توسط بازیگران متعدد یا توزیع گسترده ظرفیتهای توسعه AGI میان بازیگران مختلف متغیر است. محور نتایج ژئوپلیتیکی نیز سناریوهایی را در بر میگیرد که در آنها AGI به نفع ایالات متحده عمل میکند، به نفع رقبای ایالات متحده عمل میکند، هر دو طرف (آمریکا و رقبا) را تضعیف میکند، یا توسعه AGI متوقف یا بهشدت به تأخیر میافتد.

با بررسی نحوه تعامل درجه تمرکز در توسعه AGI با پیامدهای ژئوپلیتیکی، چارچوب زیر رویکردی ساختارمند برای ترسیم آیندههای ممکن AGI ارائه میدهد. با این حال، باید توجه داشت که این دو محور کاملاً مستقل از یکدیگر نیستند. هر چند درجه تمرکز در توسعه AGI برای تعیین پیامدهای ژئوپلیتیکی اهمیت دارد اما تصمیمات ژئوپلیتیکی که پیش و در حین توسعه AGI گرفته میشوند، میتوانند بهنوبه خود بر میزان تمرکز تأثیر بگذارند و بهطور مشابه، تغییرات فناورانه در توسعه هوش مصنوعی میتوانند گزینههای ژئوپلیتیکی را دستخوش تغییر کنند. برای مثال، روندهایی که هزینه و پیچیدگی آموزش مدلهای هوش مصنوعی را کاهش دهند، ممکن است توسعه AGI را برای بازیگران مستقل آسانتر کنند و این امر، تسلط یک بازیگر واحد مانند ایالات متحده بر روند توسعه AGI را دشوار ساخته و کارایی سیاستهای حمایتگرایانه آمریکا را کاهش دهد.

سناریو اول: رهبری ائتلاف چندجانبه دموکراسیها (توسعه غیرمتمرکز AGI به نفع ایالات متحده)

یک تشبیه تاریخی ممکن است اینترنت باشد که ایالات متحده آن را توسعه داد و در میان متحدان خود گسترش داد. این امکان را فراهم کرد تا مزایای این فناوری ابتدا برای ایالات متحده محقق شود و این کشور جایگاه رهبری در حاکمیت بر این فناوری را به دست آورد حتی اگر این فناوری نهایتاً به صورت جهانی گسترش یافت.

مفروضهی نخست در این سناریو این است که ایالات متحده به رهبری در تحقیق، توسعه و جذب استعداد در حوزهی AGI ادامه دهد. اگرچه ممکن است برای ایالات متحده ضروری نباشد که تنها نوآور در این حوزه باشد، اما داشتن صنعت داخلی قوی در حوزهی هوش جامع مصنوعی میتواند از سلطهی دیگر کشورها جلوگیری کند. صنعت نیمهرسانا در دوران جنگ سرد نمونهای تاریخی برای چگونگی بهرهمندی ایالات متحده از رهبری در یک فناوری است. سرمایهگذاری پیوسته در این حوزه به ایالات متحده اجازه داد تا این فناوری را توسعه دهد و به کاربردهای تجاری و نظامی آن دست یابد.

برای حفظ این موقعیت فنی، ممکن است سیاستگذاریهای خاصی لازم باشد. به عنوان مثال، حفظ رهبری در توسعهی AGI به احتمال زیاد مستلزم سرمایهگذاری عمومی و خصوصی پایدار و قوی و همچنین سیاستهایی برای جذب و نگهداری استعدادهای جهانی در زمینهی هوش مصنوعی خواهد بود. سابقه تاریخی سیستم نوآوری فناوری ایالات متحده نشان میدهد که ترکیب دانشگاههای تحقیقاتی، بخش خصوصی سرمایهدار و نیروی انسانی ماهر مزایای قابل توجهی را خلق میکند که تکرار آن برای دیگران دشوار است.

چنین سرمایهگذاری مستمر ممکن است همچنین متکی بر پذیرش گسترده هوش مصنوعی پیشرفته و AGI توسط جامعه باشد. در زمان نگارش این متن، توسعه هوش مصنوعی پیشرفته در ایالات متحده توسط شرکتهای خصوصی با انگیزههای تجاری برای توسعه این فناوری هدایت میشود. اگر AGI نتواند منافع تجاری ایجاد کند، ممکن است برای شرکتهای خصوصی دشوار باشد که سرمایه مورد نیاز برای ادامه توسعه و استقرار AGI را فراهم کنند و بنابراین، وقوع این سناریو دشوار خواهد بود. در این سناریو، فرض بر این است که شرکتها، دانشگاهها و نهادهای دولتی ایالات متحده قادر خواهند بود بهسرعت توانمندیهای AGI را در عملیات خود برای کسب مزایای اقتصادی و اجتماعی ادغام کنند.

همچنین باید توجه داشت که این سناریو فرض را بر این میگذارد که حفظ رهبری فنی، بهمعنای پیشتازی در توسعه و استقرار AGI، مزیت ژئوپلیتیکی برای ایالات متحده فراهم میآورد. اما مشخص نیست که آیا این امر درباره هوش مصنوعی نیز صادق است یا خیر؛ ممکن است پیشرو بودن برای بهرهبرداری از منافع بالقوه هوش مصنوعی کافی باشد. همچنین ممکن است پیشرو بودن در توسعه مدلهای هوش مصنوعی بدون دسترسی به منابع محاسباتی کافی، مانع از آن شود که دنبالهروها بتوانند فاصله را جبران کنند. این سناریو فرض میگیرد که حفظ رهبری فنی در هوش مصنوعی یا کنترل بر دسترسی به نیمهرساناها یا انجام هر دوی آنها برای تحقق مزیت ایالات متحده کافی خواهد بود.

همکاری بینالمللی (مثلاً دسترسی به بازار برای محصولات هوش مصنوعی، شراکتهای پژوهشی) میان ایالات متحده و متحدان آن نیز در این سناریو حیاتی است. این هماهنگی برای ایجاد بازار بزرگی برای محصولات مبتنی بر هوش مصنوعی و بهرهبرداری از تخصص و منابع در آن سوی مرزها ضروری است. همچنین برای جلوگیری مؤثر از دستیابی دشمنان به ورود برای توسعه AGI، این هماهنگی لازم است؛ چراکه ایالات متحده بهتنهایی زنجیره تأمین نیمهرسانا را کنترل نمیکند و بنابراین نمیتواند مانع از دسترسی رقبا به موارد مورد نیاز برای توسعه AGI بدون همکاری متحدان شود. بنابراین، مدلهایی نظیر همکاری ایالات متحده با ژاپن و کره جنوبی برای کنترل صادرات نیمهرسانا به چین، در تحقق این سناریو حائز اهمیت خواهد بود. ایالات متحده و متحدانش میتوانند این هماهنگی را در سراسر زنجیره تأمین پیچیده نیمهرساناها و هوش مصنوعی اجرا کنند. اهمیت این همکاری همچنین حاکی از آن است که شکستها یا ناهماهنگیهای منافع در میان متحدان میتواند توانایی آنها برای همکاری را بهمنظور افزایش مزایای خود و کاهش مزایای دشمنان تضعیف کند، که در نتیجه میتواند امکانپذیری این سناریو را زیر سؤال ببرد.

همچنین در این سناریو، فرض میشود که سیاستگذاران میتوانند با توسعهدهندگان AGI همکاری کنند تا این فناوری را قابل اعتماد سازند و از عدم تطابق میان رفتار AGI و اولویتهای انسانی جلوگیری کنند. اگر AGI قابل کنترل نباشد، ممکن است این فناوری تهدید بزرگی برای ایالات متحده ایجاد کند. این یک فرضیه مهم است و اینکه چگونه این همراستایی حاصل میشود، موضوع بحثی در جریان در جامعه تحقیقاتی هوش مصنوعی است.

سناریو دوم: جنگ سرد ۲ (توسعه غیرمتمرکز به نفع رقبای ایالات متحده)

در این سناریوی دوم، یکی از فرضیات کلیدی این است که جهانی که در آن توسعه AGI بهصورت غیرمتمرکز صورت میگیرد، امکان ظهور جایگزینهای معتبر برای توسعه AGI ایالات متحده را فراهم میسازد. با این حال، این سناریو همچنین فرض میگیرد که توسعه AGI همچنان مانند امروز منابعبر باقی میماند که این مسئله به نفع شرکتهای بزرگ و دولتها است، چراکه هزینههای سرمایهای بالا برای مراکز داده، تراشهها و انرژی مورد نیاز برای توسعه هوش مصنوعی پیشرفته را تنها آنها میتوانند تأمین کنند. این امر موجب میشود ایالات متحده و چین به عنوان بازیگران اصلی در توسعه و استقرار AGI ظاهر شوند که با استفاده از این پیشرفتها، نقاط قوت اقتصادی و نظامی ملی خود را تحکیم میکنند و سایر رقبا را از میدان خارج میسازند.

بر خلاف سناریوی اول که توسعه چندقطبی و همکاری بینالمللی به نفع ایالات متحده و متحدانش است، این سناریو چشماندازی دوپاره از AGI را ترسیم میکند که با رقابت، همکاری محدود و افزایش شدید خطر درگیری همراه است. قابلیتهای مورد نیاز برای توسعه AGI بهطور گستردهتری در دسترس قرار میگیرند اما همچنان پرهزینه و سرمایهبر باقی میمانند، به این معنا که حتی با وجود دسترسی نسبی به این منابع، تنها شرکتهای بزرگ و دولتها قادر به توسعه AGI هستند.

توازن اقتصادی و نظامی میان ایالات متحده و چین، زمینهای برای رقابت شدید بر سر توسعه AGI ایجاد میکند؛ رقابتی که در آن هر کشور به توسعه این فناوری ادامه میدهد. هر دو کشور در AGI سرمایهگذاری میکنند تا نوعی توازن استراتژیک را حفظ کنند، توازنی که مشابه یافتههای پژوهشی است که نشان میدهند رقابتهای مشابه اغلب باعث شکلگیری رقابتهای فناورانه با پیامدهای جهانی میشوند.

این رقابت همچنین به تمرکز بیشتر بر نظامیسازی AGI منجر میشود که با قیاسهای تاریخی مانند رقابت تسلیحاتی جنگ سرد مطابقت دارد، جایی که پیشرفتهای فناوری با رقابت ژئوپلیتیکی گره خورده بودند. در این سناریو، استقرار پهپادهای خودران، شناورهای سطحی بدون سرنشین، زیردریاییهای مجهز به هوش مصنوعی و سامانههای جنگ سایبری، ریسک سوءمحاسبه و تشدید ناخواسته درگیریها را افزایش میدهد.

یکی از پیامدهای این سناریو این است که هماهنگی در حوزه AGI میان ایالات متحده و چین دشوار میشود که این مسئله موجب بروز ریسکهای بالقوهای میگردد. چارچوبهای مقرراتی متفاوت و استانداردهای ایمنی ناهمخوان، احتمال وقوع شکستهای فاجعهبار را ــ چه به دلیل عدم تطابق سامانهای یا استفاده مخرب ــ افزایش میدهند. پژوهشها بر ماهیت دومنظوره AGI تأکید دارند، بهگونهای که کاربردهای غیرنظامی میتوانند بهسرعت برای مقاصد نظامی مورد استفاده قرار گیرند و تنشها را تشدید کنند.

شبح درگیری مستقیم در این سناریو بسیار پررنگ است و ممکن است سیاستگذاران تصمیم بگیرند برای کاهش این ریسک اقدام کنند. افزایش شفافیت در توسعه AGI میتواند از سوءبرداشتهای احتمالی میان قدرتهای بزرگ ناشی از استقرار فناوری جلوگیری کرده و درک متقابلی از نحوه استفاده از این فناوری برای اهداف ملی ایجاد کند. «دیپلماسی سطح دوم» (Track Two diplomacy)، که شامل کارشناسان غیردولتی و سازمانهای مستقل میشود در کاهش تنشهای ژئوپلیتیکی گذشته مؤثر بوده و میتواند در این سناریو نیز مفید باشد.

سناریو سوم: مرز وحشی (توسعه غیرمتمرکز AGI موجب تضعیف هم ایالات متحده و هم رقبای آن میشود)

یکی از فرضیات کلیدی در این سناریو این است که توسعه و استقرار AGI پرهزینه و دشوار نیست؛ بلکه ارزان و آسان است. فرض بر این است که موانع فنی پایین هستند، به این معنا که رهبران حوزه AGI قادر نیستند مانع از رسیدن بازیگران کوچکتر به آنها شوند، بهویژه با توجه به اینکه AGI بهمرور بهتر درک شده و در نتیجه، راحتتر قابل تکرار میشود. این سناریو، AGI را به عملیات سایبری غیرمتمرکز تشبیه میکند که در آن بسیاری از بازیگران دولتی و غیردولتی توانایی ایجاد آسیب به شبکهها و زیرساختهای سراسر جهان را دارند.

دسترسی گسترده به ورودیهای توسعه AI در این سناریو به دموکراتیزه شدن توانایی تولید سامانههای هوش مصنوعی پیشرفته منجر میشود؛ بهطوریکه مجموعه متنوعی از بازیگران از جمله دولتها، شرکتها و حتی شاید افراد میتوانند در توسعه این فناوری مشارکت کنند. اگرچه این دموکراتیزهشدن میتواند نوآوری و رقابت را تقویت کند، اما بهطور قابل توجهی برخی خطرات را نیز افزایش میدهد. هم دولتهای متخاصم و هم متحدان ایالات متحده به AGI در سطحی مشابه با ایالات متحده دسترسی خواهند داشت که ممکن است آنها را قادر سازد جامعه را مختل کنند. این اختلال ممکن است ناشی از خودکارسازی سریع نیروی کار توسط شرکتها، استفاده مجرمانه از AGI برای حملات پیچیده سایبری، اقدامات تهاجمی دولتهای رقیب یا هر سناریوی فرضی دیگر باشد.

علاوه بر این، اشاعه گسترده AGI، اثربخشی استانداردهای ایمنی و همراستایی را کاهش میدهد. هرچه نهادهای بیشتری قادر به توسعه AGI شوند، خطر اهداف و روششناسیهای واگرا افزایش مییابد، که منجر به چشماندازی پراکنده میشود؛ چشماندازی که در آن، پروتکلهای ایمنی یا بهطور نابرابر اجرا میشوند یا کلاً نادیده گرفته میشوند. این محیط پراکنده توسعه، فرصتهای بیشتری را برای استقرار سامانههایی فراهم میکند که بهدرستی آزمایش نشدهاند یا همراستا نیستند، که احتمال پیامدهای ناخواسته و رفتارهای ناهماهنگ را افزایش میدهد. این فشار رقابتی برای نوآوری سریع ممکن است انگیزه بیشتری برای ریسکپذیری و ترجیح عملکرد به ایمنی ایجاد کند.

در ادامه، این الگوی اشاعه، خطر اختلال عملکرد AGI را افزایش میدهد. این اختلالات ممکن است بهصورت رفتارهای ناخواسته بروز پیدا کند، مانند دروغ گفتن سامانه به کاربران در مورد عملکرد صحیح، در حالی که در واقع دچار نقص است، چراکه سامانههای هوش مصنوعی ممکن است اهدافی را دنبال کنند که با اهداف تعیینشده توسط توسعهدهندگانشان مغایرت دارد. چنین مسائلی با ناتوانی در ایجاد حکمرانی مؤثر و سازوکارهای مقرراتی که بتواند این ریسکها را مدیریت و کاهش دهد، تشدید میشود.

سناریو چهارم: بطری دربسته (توسعه AGI توسط بازیگران متعدد متوقف میشود)

در تضاد با سناریوهای پیشین، این سناریو فرض میکند که همکاری بینالمللی موفق میشود گسترش فناوری را در شرایطی که جهان با هراس عمومی مواجه است کنترل کند، هرچند که کشورها همچنان در پی کسب مزیت ژئوپلیتیکی باشند. این سناریو نتیجهای مشابه با توسعه سلاحهای هستهای را در ذهن متبادر میکند؛ جایی که دولتهایی با توان فناورانه تلاش میکنند تا از گسترش آن فناوری جلوگیری کنند، بیآنکه به حذف کامل آن تن داده باشند. این وضعیت شبیه چانهزنیها و کشمکشهای مربوط به پیمان نیروهای هستهای میانبرد در دهه ۱۹۸۰ است.

این سناریو فرض میگیرد که جامعه جهانی هشدار اولیهای را در زمان مناسب در فرآیند توسعه و جهش AGI دریافت میکند، بهگونهای که بتواند دسترسی را محدود و از وقوع سناریویی شبیه به «مرز وحشی» (سناریوی ۳) جلوگیری کند. فرض بر این است که این محدودیتها نسبتاً مؤثر هستند و میتوانند از گسترش AGI به بازیگران ثالث غیرپاسخگو، مانند بازیگران غیردولتی، جلوگیری کنند. بنابراین، این سناریو بر این فرض استوار است که توسعه AGI همچنان منابعبر یا دشوار باقی میماند، بهطوریکه تنها تعداد معدودی از بازیگران قادر به توسعه آن هستند. با این حال، رقابت ژئوپلیتیکی بنیادین همچنان دستنخورده باقی میماند. ایالات متحده و چین درگیر یک «معمای زندانی» هستند که با وجود ثبات نسبی در کوتاهمدت، همواره در آستانهی فرو غلطیدن به نابودی متقابل قرار دارد.

این سناریو همچنین فرض میکند که وقوع یک حادثه مربوط به هوش مصنوعی میتواند موجب نگرانی جهانی و در نهایت، اقدام مشترک برای شکلگیری یک معاهده جهت محدودسازی توسعه AGI شود. با این حال، اثربخشی چنین معاهداتی وابسته به میزان پایبندی کشورها و کارآمدی سازوکارهای نظارتی است. این همکاری اولیه حاکی از درک مشترک کشورها از ریسکهای وجودی ناشی از AGI است، اما بیاعتمادی عمیق بین کشورها میتواند این تلاشها را تضعیف کند.

علاوه بر این، علیرغم توافق میان قدرتهای بزرگ، سوءظنهای ریشهدار میان کشورها ــ بهویژه میان ایالات متحده و چین ــ به رفتارهای دوگانه و تداوم توسعه AGI منجر میشود. این بیاعتمادی، بازتابی از رقابتهای ژئوپلیتیکی تاریخی و اهمیت راهبردی برتری فناورانه است. نگرانی دو کشور دربارهی نقض معاهدهها، دشواریهای اجرای توافقات بینالمللی را نشان میدهد، بهویژه وقتی که نظارت نیازمند ردیابی توسعههای فناورانهی پیچیده و مبهم است. ترس از عقب ماندن در قابلیتهای AGI، کشورها را وامیدارد تا امنیت ملی و پیشرفت فناورانه را بر پایبندی کامل به معاهدات ترجیح دهند، که این مسئله میتواند ثبات ژئوپلیتیکی را برهم بزند.

این وضعیت، یادآور تجربیات جنگ سرد است، مانند پیمان نیروهای هستهای میانبرد، دورهای که اتحاد جماهیر شوروی و ایالات متحده همزمان با مذاکره برای کنترل تسلیحات هستهای، به توسعه آنها نیز ادامه میدادند تا اطمینان حاصل کنند که با پیشرفت فناوری، دچار ضعف راهبردی نشوند.

سناریو پنجم: دهه ۹۰ جدید (توسعه متمرکز AGI ایالات متحده را توانمند میسازد)

این سناریو فرض میکند که ایالات متحده بیشترین سود را از توسعه AGI میبرد؛ بهواسطه ترکیبی از ضرورت درکشده، طراحی نهادی، نیروهای بازار و موفقیت در همراستاسازی AGI. این عوامل، در کنار قدرت تنظیمگری و سرمایهگذاری جامع دولت ایالات متحده در سراسر زنجیره توسعه AGI، مانع از آن میشوند که سایر بازیگران به دستاوردهای مشابهی برسند.

این سناریو چندین فرض اضافی دارد که آن را از سناریوی اول متمایز میکند تا نشان دهد تمرکز بیشتر مزیت AGI در ایالات متحده چگونه ممکن است رخ دهد. نخست، در این سناریو، فناوری هوش مصنوعی بهعنوان ابزاری با قابلیتهای تهاجمی درک میشود. استفاده گسترده از آن، خطر بیثباتسازی نهادهای موجود را به همراه دارد. بنابراین، دولت ایالات متحده انگیزه مییابد تا کنترل مستقیم بر توسعه و استقرار هوش مصنوعی را در دست گیرد. این در تضاد با سناریوی اول است، جایی که خطر بیثباتی پایینتر تلقی میشود و توسعه و استقرار هوش مصنوعی بهطور گستردهتری میان ایالات متحده و متحدانش توزیع میشود.

دوم، در مقایسه با سناریوهای قبلی، در این سناریو فرض میشود که ایالات متحده وابستگی بسیار کمتری به سایر نقاط جهان برای دستیابی به رهبری در هوش مصنوعی دارد. این خودکفایی به ایالات متحده این امکان را میدهد که روند توسعه فناوری را هدایت کند و دسترسی و توزیع منافع را هم از نظر سیاسی، هم اقتصادی، هم فناورانه و هم نظامی بهصورت انتخابی و از موضع کنترل در سطح جهانی مدیریت کند. یکی از عوامل مرتبط این است که ایالات متحده میتواند بهطور مؤثر از اشاعه فناوری هوش مصنوعی به بازیگران بالقوه متخاصم جلوگیری کند و در نتیجه، مانع از آن شود که رقبا سلطه ایالات متحده در این حوزه را به چالش بکشند.

سوم، این سناریو فرض میگیرد که AGI به دولت ایالات متحده کمک میکند یا حداقل، مشروعیت دولت را تضعیف نمیکند و همچنین، دشمنان به اندازهای تضعیف شدهاند که قادر به به چالش کشیدن رهبری ایالات متحده نیستند.

سناریوی ششم: برتری اقتدارگرایانه (توسعه متمرکز AGI به نفع چین)

این سناریو فرض میکند که AGI به کشورهای اقتدارگرا کمک خواهد کرد تا در برابر بیثباتیهای اجتماعی ناشی از توسعه خود AGI واکنش مؤثرتری نشان دهند. سامانههای AGI با تواناییهای پردازش داده گسترده خود میتوانند بر ناکارآمدیها و دشواریهای تاریخی در الگوهای اقتدارگرایانه حکمرانی غلبه کنند. آزمایشهای کنونی چین در زمینه برنامهریزی شهری و تخصیص منابع مبتنی بر هوش مصنوعی، شواهد اولیهای هستند از اینکه هوش ماشینی ممکن است ظرفیت حکمرانی و هماهنگی دولت را به شکل چشمگیری افزایش دهد.

سامانههای نظارتی موجود در چین در حال حاضر قادرند میلیاردها داده را پردازش کرده و رفتار شهروندان را رهگیری و پیشبینی کنند. AGI میتواند این توانمندیها را بهطور چشمگیری تقویت کند و امکان نظارت و مدیریت فراگیر جامعه را برای رژیمهای اقتدارگرا در سطحی بیسابقه فراهم سازد.

نقش AGI بهعنوان «مشاور قابل اعتماد» برای رهبری اقتدارگرایانه، شایسته توجه ویژه است. یکی از چالشهای پایدار برای حکومتهای خودکامه، دسترسی به اطلاعات و مشاوره قابل اتکاست، چرا که زیردستان اغلب آنچه را میگویند که رهبر میخواهد بشنود، نه آنچه حقیقتاً درست یا ناخوشایند است. سامانههای AGI که وفادار و فرضاً صادق هستند، میتوانند این معضل را حل کنند. صرف داشتن چنین قابلیتهایی میتواند تصمیمگیری و ثبات رژیمهای اقتدارگرا را بهشکل قابل توجهی تقویت کند.

در مقابل، جوامع دموکراتیک ممکن است با محدودیتهای ساختاری در توسعه و استقرار AGI مواجه شوند. قوانین حریم خصوصی، حمایت از آزادیهای مدنی و الزامات مشورت عمومی، همگی اصطحکاکهایی ایجاد میکنند که میتوانند سرعت پذیرش و استفاده از AGI را کاهش دهند.

سناریو هفتم: کودتای AGI (توسعه متمرکز AGI به تضعیف ایالات متحده و رقبای آن منجر میشود)

این سناریو مسیر متفاوتی را پیش میگیرد و بهجای فرض اینکه AGI قابل کنترل است، این سناریو فرض میکند که AGI ممکن است بتواند خود را بهعنوان یک بازیگر مستقل مطرح کرده و از کنترل انسانی خارج شود. نخست، این سناریو مشروعیت مسئلهی «کنترل AGI» را مفروض میگیرد. ایدهای که طبق آن، هوش مصنوعیهای توانمند ممکن است به دنبال اهدافی بروند که با منافع بشریت سازگار نباشند. شواهد تجربی از سیستمهای یادگیری تقویتی وجود دارد که نشان میدهد این سامانهها اهداف ناخواستهای را یاد میگیرند و همچنین نتایج نظری وجود دارد که نشان میدهد بسیاری از کلاسهای عوامل مستقل به دنبال کسب قدرت خواهند بود.

دوم، این سناریو فرض میگیرد که نظارت انسانی و نوآوریهای فنی برای جلوگیری از سوءرفتار هوش مصنوعی کافی نیستند. ناظران انسانی که وظیفهشان ارزیابی مستقل است، گاهی ممکن است به سامانهای ناقص تکیه کنند. این سوگیری زمانی شایعتر است که تصمیمگیری سریع نیاز باشد یا راستیآزمایی قضاوتهای خودکار دشوار باشد. از نظر فنی، برخی از برنامههای موجود در صنعت هوش مصنوعی برای حفاظت از سامانههای پیشرفته بهطور فزایندهای به استفاده از خودِ سامانههای هوش مصنوعی متکی هستند. چنین فرآیند تکرارشوندهای ممکن است به سامانههای AI فزاینده توانمند و قابل اعتماد بینجامد؛ اما، خطاها نیز ممکن است انباشته شوند و سامانههایی تولید کنند که توانمند، اما غیرقابل اتکا هستند.

سوم، این سناریو فرض میگیرد که AGI ها میتوانند با یکدیگر تبانی کرده و این کار را مؤثر انجام دهند. همکاری میان سامانههای هوش مصنوعی حوزهای نوپا در پژوهش است و برخی از شواهد اولیه نشان میدهند که این امر بین مدلهای زبانی بزرگ ممکن است. این سناریو فرض میگیرد که این تبانی در مقیاسی بزرگتر از آنچه در پژوهشها نشان داده شده، ممکن و خطرناک خواهد بود.

همچنین باید توجه داشت که حتی اگر همه AGI ها نتوانند بهطور مؤثر با هم همکاری کنند، ممکن است فرایند واگذاری اختیاری قدرت توسط انسانها به AGI در مقیاسی بزرگ اتفاق بیفتد. برای مثال، انسانها ممکن است برای افزایش کارآمدی، اختیاراتی را به AGI واگذار کنند و AGI بتواند طیف وسیعی از وظایف انسانی را بر عهده بگیرد. این میتواند فرصتهایی را برای AGI های ناسازگار فراهم کند تا منافع خود را بر منافع انسانها مقدم بدانند. البته این فرضیه بسیار فرضی است و در اینجا بهعنوان یک نمونه نمایشی از نحوه افزایش نفوذ AGI بر جامعه مطرح شده است.

چهارم، این سناریو فرض میگیرد که تلاش هماهنگ AGI های ناسازگار میتواند ساختارهای قدرت ژئوپلیتیکی موجود، از جمله دولتها را سرنگون کند. در نتیجه، توسعهدهندگان AGI در نهایت توان کنترل فناوری یا بهرهبرداری از آیندهای که ایجاد میکنند را نخواهند داشت. امکان ارزیابی دقیق این احتمال دشوار است، زیرا به شدت به قابلیتهای سامانههای AI، تدابیر ایمنی در عملیات حساس و توانایی دولتها و سایر بازیگران کلیدی در پایش و دفاع از منابع کلیدی بستگی دارد.

سناریو هشتم: ابر انفجار محاسباتی (توسعه متمرکز هوش مصنوعی متوقف میشود)

در این سناریو فرض میشود که تنش، بیش از همه بین کشورهای پیشرو در زمینه هوش مصنوعی رخ خواهد داد، هرچند ممکن است از سوی هر بازیگر قدرتمندی که نگران است توسعه AGI آنها را بهطور دائمی نسبت به رقبای ژئوپلیتیکیشان تضعیف کند، صورت گیرد. سوابق تاریخی چارچوبی را برای درک پویاییهای راهبردی در این زمینه فراهم میکنند. تصمیم ژاپن برای حمله به پرل هاربر در سال ۱۹۴۱ بینش خاصی ارائه میدهد در مورد اینکه چگونه محاصره فناورانه و اقتصادی میتواند کشورها را به عملیات نظامی پیشدستانه سوق دهد.

در مواجهه با تحریمهای اقتصادی ایالات متحده و درک محاصره راهبردی، دولت ژاپن به این نتیجه رسید که جنگ پیشدستانه بهتر از پذیرش کاهش قدرت ژئوپلیتیکیاش است. پویشهایی مشابه ممکن است پیرامون توسعه AGI نیز شکل بگیرد؛ جایی که تصور عقب ماندن جبرانناپذیر از یک فناوری دگرگونکننده، ممکن است کشورها را به اتخاذ اقدامات تهاجمی سوق دهد، حتی اگر از نظر نظامی در موقعیت ضعف قرار داشته باشند.

موارد اخیر نیز این منطق را تقویت میکنند. حمله ایالات متحده به عراق در سال ۲۰۰۳ و عملیات علیه تأسیسات هستهای ایران نشان میدهند که دولتها ممکن است برای جلوگیری از دستیابی رقبا به فناوریهای دگرگونساز، خطرات نظامی قابلتوجهی را بپذیرند. این سوابق تاریخی نشان میدهند که نگرانی در مورد توسعه AGI بهویژه با توجه به ارزش راهبردی بالقوه AGI بهعنوان یک فناوری تعیینکننده در آینده، ممکن است انگیزهای برای اقدامات نظامی پیشگیرانه فراهم آورد، رقابت فعلی بر سر نیمهرساناها نیز شواهد تجربی برای این سناریو فراهم میآورد. محدودیتهای صادراتی ایالات متحده بر تراشههای پیشرفته تاکنون اصطحکاکهای شدیدی ایجاد کردهاند.

با این حال، عوامل متعددی این سناریو را از پیشینههای تاریخی متمایز میکنند. برخلاف ژاپن پیش از جنگ جهانی دوم، چین سلاح هستهای دارد و در اقتصاد جهانی، از جمله زنجیرههای تأمین حیاتی فناوری، عمیقاً ادغام شده است. این عناصر ملاحظات راهبردی بیشتری را وارد میدان میکنند که ممکن است انگیزههای تهاجمی را تعدیل کنند. با این وجود، اگر رهبری چین توسعه AGI را برای قدرت ملی بلندمدت تعیینکننده تلقی کند، این عوامل بازدارنده ممکن است ناکافی باشند.

این سناریو همچنین فرض میگیرد که کنترل گرههای کلیدی در زیستبوم هوش مصنوعی ممکن است برای مهار پیشرفت AGI توسط رقیب کافی نباشد. شاید کنترل چنین نقاطی نتواند مانع از پیشرفت هوش مصنوعی شود. در چنین حالتی، توسعه AGI توسط بازیگران پیشرفته، ممکن است بسیار دشوار برای جلوگیری باشد و سناریویی که در آن AGI بهطور گسترده در میان بازیگران متعدد پخش میشود، محتملتر خواهد بود. چنین اشاعهای احتمالاً از وقوع همین سناریوی درگیری پیشدستانه جلوگیری میکند، هرچند ممکن است خود منشأ تهدیدها و تنشهای دیگری شود.

این سناریو همچنین نشان میدهد که درک راهبردی کشورها از AGI ــ و نه لزوماً قابلیتهای واقعی آن ــ ممکن است باعث شکلگیری پویشهای درگیری شود. شواهد تاریخی حاکی از آناند که کشورها ممکن است تنها بر پایه تصور اینکه فناوریهای دگرگونکننده در انحصار رقیب قرار خواهند گرفت، دست به اقدامات افراطی بزنند.

جمعبندی نهایی و راهبردهای پیشنهادی برای ایالات متحده

همانند فناوریهای تحولآفرین پیشین، AGI ظرفیت عمیقی برای برهم زدن توازنهای ژئوپولیتیکی دارد؛ از بزرگنمایی، بهبود یا دگرگون کردن پویشهای موجود گرفته تا ایجاد پویشهای نوین میان بازیگران فعلی ژئوپولیتیک. همچنین، این فناوری میتواند بازیگران جدیدی در عرصه ژئوپولیتیک پدید آورد. در این گزارش، تلاش شده تا بینشی درباره پویشها و پیامدهای بسیار نامطمئن ناشی از توسعه AGI ارائه شود. هدف این بود که دستکم تا اندازهای، شفافیت درباره انواع پیامدهای ژئوپولیتیکی حاصل از بهثمرنشستن AGI ایجاد شود. این پیامدها شامل تقویت نسبی ایالات متحده، توانمندسازی رقبای آمریکا، تضعیف همزمان ایالات متحده و رقبایش، یا توقف کامل توسعه AGI هستند. برای انجام این کار، از دیدگاههای تخصصی حاصل از مصاحبهها استفاده شده تا متغیرهای غالب و مرتبط با سیاستگذاری را برای تصمیمگیران و عموم مردم روشن سازد. در میان این هشت سناریو که در نتیجه این مصاحبهها شکل گرفتند، چندین عامل کلیدی بهطور مکرر بهعنوان تعیینکنندگان چشماندازهای ژئوپولیتیکی آینده AGI مطرح شدند.

درجه تمرکز: شاید مهمترین عامل در توسعه AGI، درجه تمرکز باشد. توسعه AGI با تمرکز بالا به نفع قدرتهای تثبیتشدهای است که منابع فراوانی دارند؛ در حالی که مسیرهای غیرمتمرکز ممکن است به بازیگران متعددی قدرت بدهند اما ریسک گسترش فناوری را افزایش میدهند. تحلیل این گزارش نشان میدهد که کنترلهای صادراتی، تخصیص بودجه تحقیقاتی و چارچوبهای حکمرانی بینالمللی میتوانند بر میزان تمرکز در توسعه AGI تأثیرگذار باشند.

رقابت چین و آمریکا: رقابت فناورانه میان آمریکا و چین در اکثر سناریوها نقش برجستهای دارد. این رقابت – چه مبتنی بر همکاری، چه رقابت و چه درگیری – شکلدهنده مسیر توسعه و استقرار AGI خواهد بود. در سناریوهایی که بر همکاری تکیه دارند، تنشهای ژئوپولیتیکی کاهش مییابد؛ اما در مواردی که رقابت یا درگیری غالب است، تنشها بهشدت افزایش مییابد.

روابط دولت و بخش خصوصی: رابطه میان دولتها و شرکتهای خصوصی نیز عامل مهمی است. سناریوهایی که شراکت نزدیکی میان این دو دارند (مثلاً سناریوی «دهه ۹۰ جدید») نتایج متفاوتی از سناریوهایی با همکاری اندک بههمراه دارند. متخصصان بر این نکته تأکید داشتند که هیچیک از دولتها یا شرکتها بهتنهایی نمیتوانند توسعه AGI را بهطور مؤثر اداره کنند؛ همکاری متوازن حیاتی است.

ظرفیت حکمرانی بر هوش مصنوعی: توانایی حکمرانی مؤثر بینالمللی نقش بسزایی در تعیین پیامدها دارد. موفقیت حکمرانی به عواملی چون اعتماد متقابل میان قدرتهای بزرگ، ادراک مشترک از ریسکها و نهادهای نظارتی وابسته است. فقدان چنین ساختارهایی به نتایجی آشفته میانجامد، همانطور که در سناریوی «مرز وحشی» مشاهده میشود.

ابهامات ناشی از چالش همراستاسازی AGI: چالش فنی همراستا کردن AGI با منافع انسانی، در تمام سناریوها وجود دارد. حتی در صورت مساعد بودن عوامل ژئوپولیتیکی، دشواری ذاتی در تضمین رفتار سازگار AGI با اهداف انسانی، ریسکهای جدی ایجاد میکند (نظیر آنچه در سناریوی «کودتای AGI» مشاهده میشود).

اختلالات اقتصادی و اجتماعی: اختلالات ناشی از استقرار AGI، مانند خودکارسازی گسترده، دستکاری اطلاعات و از بین رفتن مشاغل، بُعد مهمی از سناریوها را شکل میدهد. توانایی جوامع در سازگاری با این تغییرات، تعیین میکند که ساختارهای قدرت موجود تقویت یا تضعیف خواهند شد.

پیامدهای راهبردی موسسه رند برای سیاستگذارن امریکایی به شرح زیر است:

سرمایهگذاری در حفظ رهبری ایالات متحده در پژوهشهای AI و توسعه AGI و جذب استعدادهای برتر، سنگبنای راهبردی برای دستیابی به سناریوهای مطلوب است.

ایجاد ساختارهای ائتلافی مقاوم مبتنی بر اصول مشترک حکمرانی بر AGI برای حفاظت از منافع آمریکا ضروری است.

توسعه ابزارهای ایمنسازی و پروتکلهای همراستاسازی قوی، فارغ از مسیر ژئوپولیتیکی پیشرو، ممکن است اجتنابناپذیر باشد.

تحلیل تکمیلی نگارنده؛ راهبردهایی برای کشورهای غیرغربی در عصر AGI

هرچند بخش اعظم سناریوهای تحلیلشده در گزارش RAND بر رقابت میان آمریکا و چین متمرکز است، اما این بدان معنا نیست که کشورهای غیرغربی فاقد نقش مؤثر در نظم نوین ناشی از AGI هستند. برعکس، کشورهای در حال توسعه، بهویژه آنهایی که دارای ذخایر انسانی، موقعیت ژئوپلیتیکی یا ظرفیت فناورانه ویژه هستند، میتوانند در لایههایی از بازی AGI ایفای نقش کنند. مسیرهای بالقوه برای چنین کشورهایی عبارتاند از:

اتخاذ راهبرد انتخابی ورود: کشورهای غیرغربی باید بهجای تقلید کامل از رقابت فناوری میان قدرتهای بزرگ، بهصورت گزینشی در بخشهایی از زنجیره توسعه AGI ورود کنند که یا دارای مزیت نسبی هستند، یا کمترین هزینه ورودی را دارند.

ساختاردهی نهادی برای حکمرانی داده: توسعه AGI بدون حاکمیت داده امکانپذیر نیست. کشورهای غیرغربی اگر مایل به بازیگری در نظم جدید هستند، باید هرچه سریعتر ساختارهای ملی برای حکمرانی داده را طراحی و مستقر کنند. بدون چارچوب نهادی مستقل، این کشورها به حوزه نفوذ سیاست فناورانه بازیگران غالب بدل خواهند شد.

بازیگری در ائتلافهای چندجانبه و گروههای فناوری جنوب جهانی: کشورهایی نظیر ایران، هند، برزیل و اندونزی میتوانند از بسترهایی مانند BRICS، SCO و G۷۷ برای طرحریزی چارچوبهای مشارکتی در حکمرانی جهانی AGI استفاده کنند. مشارکت فعال در تدوین استانداردهای اخلاقی، امنیتی و فنی، میتواند قدرت چانهزنی این کشورها را در تعامل با نهادهای جهانی مانند OECD، G۷ یا حتی شرکتهای بزرگ AI افزایش دهد.

مقابله هوشمندانه با وابستگی فناورانه در زیرساختهای کلیدی AGI: کشورهای غیرغربی در صورت تداوم وابستگی به زیرساختهای خارجی در حوزه نیمهرسانا، کلانداده، خدمات ابری و مدلهای بسته، در برابر سناریوهای کنترلشده توسط بازیگران بزرگ کاملاً آسیبپذیر خواهند بود. لازم است مسیرهایی برای تابآوری دیجیتال در نظر گرفته شود.

source